CENTRE NATIONAL D'ETUDE SPATIALES

Groupe d'Etude des Phénomènes Aérospatiaux Non-identifiés

|

Toulouse, le 29 octobre 1979 |

NOTE TECHNIQUE N°1

Analyse du problème

du pré-traitement des données

SOMMAIRE

CHAPITRE 1 - Les techniques d'expertise

( Alain ESTERLE )

CHAPITRE 2 - Règles de codage ( 4ème version GEPAN )

( Jacques DUVAL )

CHAPITRE 3 - Rapport d'études statistiques

( Paul LEGENDRE )

CHAPITRE 4 - Réflexion sur les principes du pre-traitement

( Manuel JIMENEZ )

CHAPITRE 5 - Etude des problèmes liés à la création d'un fichier informatique

( Jean-Pierre ROSPARS )

CHAPITRE 6 - Les méthodes de traitement de I'information appliquées aux phénomènes OVNI

( Michel MARCUS )

CHAPITRE 6

LES MÉTHODES DE TRAITEMENT DE L'INFORMATION APPLIQUÉES AUX PHENOMENES OVNI

Par Michel MARCUS ( Stagiaire Ecole Centrale )

1. INFORMATION

1.1. PRINCIPE

Nous avons examiné au cours du chapitre 4 la manière dont l'expert était appelé à qualifier le document ou témoignage qui lui était soumis.

Nous avons cherché dans la direction suivante "Quelle est la quantité d'information apportée par un rapport ?".

Nous avons donc cherché dans la théorie de l'information ce qui pouvait être utilisable pour notre problème. Avant de conclure sur l'intérêt de cette théorie pour le problème OVNI, notons simplement que le nom "théorie de l'information" est un peu mal choisi car c'est plutôt une théorie de la communication qu'a élaborée : SHANNON.

1.2. THEORlE DE L'INFORMATION

Définition :

Soit un évènement E qui est réalisé avec une probabilité p(E). Si on apprend que E est réalisé, on

dira que l'information reçue est I = -log p(E). Choix de l'unité I = -log2 p(E) est exprimer en bit.

Modèle de la source sans mémoire Soit une source S émettant des symboles venant d 'un alphabet A = s1, s2, ..., sq avec des probabilités d'occurence P (s1), P (s2), . . . P (sq).

On peut calculer l'information moyenne procurée par une source sans mémoire de la façon

suivante :

Si un symbole si apparaît, on obtient une information

I (si) = -log P (si)

la probabilité que cela arrive est P(si) donc la quantité moyenne d'information par

symbole de la source est :

![]()

On appelle cette quantité l'entropie de la source.

Propriété :

![]()

Définition :

![]()

Extension :

Soit deux sources S1 et S2 indépendantes, émettant ensemble et

constituant ainsi S alors :

H(S) = H(S1) + H(S2)

Modèle de source de MARKOV :

Ici l'occurrence d'un symbole si dépend des m symboles précédents source d'ordre m :

![]()

Estimation de l'entropie :

On veut estimer l'entropie d'une source à partir de l'observation de N sorties.

On a :

![]()

Et :

![]()

1.3. APPLICATION

Considérons le fichier informatique :

Considérons une colonne ( la forme par exemple ). La suite des symboles du codage de cette colonise peut être considérée comme une source d'information émettant cette suite de symboles.

En évaluant les proportions de chaque signe, on peut estimer les probabilités d'occurence et partant, la quantité d'information contenue dans un signe et la quantité d'information moyenne de la source ou en entropie.

1.4. COMMENTAIRES

Le défaut majeur de cette opération est que pour chaque colonne du fichier, un des symboles du codage note le manque d'indication de la variable. Et ce symbole est considéré comme ayant même valeur que les autres.

On pourra donc arriver au paradoxe suivant : supposons que, à un moment donné, tous les témoignages ont donné une indication du département, et qu'un témoignage arrive sans indication du département, on trouvera que ce document apporte beaucoup d'informations.

2. ÉTUDES STATISTIQUES

L'objectif est d'essayer de dégager des propriétés du phénomène OVNI, à partir de ces

observations prises collectivement.

Il est entendu que ces résultats dépendront du codage.

2.1. PHOTOGRAPHIE DU FICHIER

Pour chaque critère du codage, on établit les pourcentages respectifs des modalités de ce critère.

Exemple :

| Nombre de témoins : | 3,8 % information non disponible |

| ( sur 106 cas D ) | 2,8 % de 0 à 13 ans |

| 13,2 % de 14 à 20 ans | |

| 68, 9 % de 21 à 59 ans | |

| 11,3 % de 60 ans et plus |

Le chapitre précédent sur la théorie de l' information donne, par exemple, un autre moyen de photographier le fichier, en permettant le calcul de I'entropie de la source à partir d'une estimation basée sur les fréquences observées.

Exemple :

- Nombre de témoins :

| en bits = 1,43 bits |

Une autre visualisation du fichier est de considérer non plus les pourcentages mais les quantités

réelles. Cela donne une suite de valeurs dont on peut extraire la moyenne, le moment d'ordre 2,

d'ordre 3, etc…

Exemple :

Nombre de témoins ( sur 106 cas ) :

xi 4/1 . 3/2 . 14/3 . 73/4 . 12/5

| x=21,20 m2=689,36 m3=25344,58 |

Ces diverses manipulations sont à faire à la fois pour tout le fichier des observations non-identifiées par le témoin, ainsi que pour les classes A, B, C et D, ce qui permet de caractériser le phénomène OVNI.

Tous ces nombres ( %, entropie, moyenne, dispersion ) sont un résumé de l'ensemble du fichier. Leur évolution dans le temps montrera l'évolution du fichier et donc des observation.

2.1.1. Age des témoins

La 3ème version du codage ne donnait que les 4 modalités suivantes pour l'âge, soit :

| E : | de 0 à 13 ans |

| J : | de 14 à 20 ans |

| A : | de 21 à 59 ans |

| V : | de 60 ans et + |

La 4ème version (1) est plus précise car elle donne l'âge en clair ( ou ** si inconnu ).

(1) cette 4ème version est celle explicitée au chapitre 2.

2.1.2. Heure de l'observation

Le codage dans le fichier est le suivant :

| heure | h h m n e | | estimation |

| locale | 0 2 3 0 Z |

CODE :

| 16 - M : | matin | 3 - V : | Vers midi | |

| 4 - P : | après midi | 4 - S : | Soirée | |

| 10 - C : | crépuscule | 15 - D : | début de la nuit | |

| 50 - Z : | vers minuit | 18 - F : | fin de la nuit | |

| 3 - L : | aurore |

Les règles ne donnent pas le passage heure --> estimée. En regardant le fichier, on trouve par

exemple :

2230D et 2230Z.

On peut penser que la date y est pour quelque chose, effectivement le 1er se trouve en juin, l'autre en octobre. Dans la mesure où l'heure est indiquée tout le temps, on doit trouver une certaine corrélation entre mois, heure et estimée, ou mis autrement, il y a redondance entre ces données. Cette redondance est inutile et se reportant à un travail sur les diagnostics automatiques, cela serait même préjudiciable à une classification automatique.

Pour la représentation graphique, à part l'histogramme que nous avons présenté, on peut penser à un diagramme "polaire" ( cf. sémiologie graphique BERTIN ).

3. ANALYSE DE DONNEES

3.1. ANALYSE MULTIDIMENSIONNELLE

Citons les résultats d'une étude conduite par le GEPAN. Les données étaient constituées par 736 observations d'OVNI, qui ont été mises sous forme d 'un tableau homogène de 736 lignes et 219 colonnes.

Premier traitement :

Construction d'un tableau croisant la description des conditions de l'observation ( 111 modalités ) et la description de l'observation ( 108 modalités ).Résultats :

- le nuage est assez sphérique ;

- l'angle entre les hypers plans : condition et description, est proche de 90° ;

- le 1er axe oppose les évènements bien décrits aux évènements peu décrits ;

- le 2ème axe semble lié aux conditions d'observation.

Conclusions :

Les tendances observées apportent peu de révélations et permettent difficilement de dresser une typologie.Deuxième traitement :

Construction d'un tableau ( 124 x 124 ) croisant les descriptions des observations avec elles- mêmes.Résultats :

- le nuage est assez sphérique ;

- l'angle des deux hypers-plans est proche de 70° ( liaison globale plus forte que précédemment ) ;

- le 1er axe factoriel s'interprète facilement comme étant la distance d'observation ;

- le 2ème axe s'interprète comme étant la durée de l'observation.

3.2. CONCLUSION

Il semble que la méthode d'analyse utilisée permette de mettre en évidence certains éléments structuraux.

Il serait donc approprié de l'utiliser aussi pour les objets identifiés.

En premier lieu, son élaboration et amélioration tiendraient compte des résultats des expertises des objets ce qui garantirait en second lieu son emploi pour les objets non-identifiés, et enfin donnerait peut-être un outil pour une expertise plus ou moins automatique, chaque observation arrivant étant prise comme un élément supplémentaire.

4. LES ESSAIS DE MODÉLISATION

4.1. PERCEPTION

Nous allons présenter ici une étude de C. POHER dont le but était de montrer que les observations d'OVNI ne correspondaient pas a des hallucination ou canulars. Nous avons changé quelques détails mineurs dans cette étude.

Plus un objet est lumineux, plus il est probable qu'il soit perçu. Si toutes les luminosités sont représentées uniformément, une observation prise au hasard est plus probablement celle d'un objet très lumineux que peu, ou, des classes d'objets lumineux rangées par proportion croissants donnent une échelle de luminosité croissants.

Il faut donc trouver un moyen de passer d'une échelle de proportion à une échelle de luminosité ( ou brillance ).

Pour une classe d'objets représentant toutes les luminosités :

B varie de 0 à + l'infini

log B varie de - infini à + infini

Pour une classe d'objets représentant uniquement des luminosités faibles : B varie de 0 à 1 ( par exemple ) log B varie de - l'infini à 0

On vent pour ces deux classes, pouvoir passer des proportions de sous-classes constituant la classe entière à des valeurs sur l'axe "log B".

1ère classe :

On veut passer de 0 < proportion < 1 à - infini < log B < + infini

Les fonctions y = lambda log (x/(1-x)) effectuent ce passage.

2ème classe :

On veut passer de 0 < proportion < 1 à - infini < log B < 0

Les fonctions y = lambda log x effectuent ce passage.

OBTENTION DE LA LOI DE BOUGUER :

|

épaisseur de l'atmosphère : d l=d/sin h |

Décroissance exponentielle de l'intensité lumineuse à travers un milieu d'épaisseur x :

B = Bo e-kx

Donc ici :

B = Bo e-kl = Bo e-kd/sin h

log B = - (kd/sin h) + log Bo

k et d étant sensiblement constant

log B = - (C1/sin h) + C2

Cette loi donne donc la variation de la magnitude en fonction de la hauteur angulaire d'un même objet vu d'endroits différents.

LOI DE BOUGUER :

Condition d'application : astronomie - étoiles

Expression :

Comment vérifier cette loi ? :

Choisir parmi les observations celles dont les caractéristiques se rapprochent au mieux des conditions d'applicabilité de la loi ;

Partitionner les observations en classes de hauteur angulaire, calculer les portions de chaque classe, effectuer le passage de ces proportions à une échelle de luminosité, et porter les résultats dans le plan "plan de BOUGUER" ainsi redéfini.

Réalisation du test :

- Choix des valeurs de h dans chaque classe de hauteur angulaire,

- Choix des critères à retenir dans le fichier d'observation.

Hauteur angulaire moyenne :

- * pas d'indication

- 1 de 0 à 15°

- 2 de 15 à 30°

- 3 de 30 à 45°

- 4 de 45 à 60°

- 5 de 60 à 90°

- 6 au-dessus de l'horizon (avion)

- 7 avion ou au-dessus

- 8 au sol ou près du sol

- . autres types

Dans le cas présent, on s'intéresse aux modalités :

1 U 2 U 3 U 4 U 5.

On a donc deux modalités d'emploi :

- moyenne,

- borne supérieure.

Moyenne :

| CLASSES | MOYENNE | 1/sin h |

| 1 | 7° 30' | 7,66 |

| 2 | 22° 30' | 2,61 |

| 3 | 37° 30' | 1,6 |

| 4 | 52° 30' | 1,26 |

| 5 | 75° | 1,03 |

Borne supérieure :

| CLASSES | MOYENNE | 1/sin h |

| 1 | 15° | 3.86 |

| 2 | 30° | 2 |

| 3 | 45° | 1,41 |

| 4 | 60° | 1,15 |

| 5 | 90° | 1 |

Critères :

- CR 5 : type de témoignage : 1 lumière nocturne

- CR 17: distance minimale : 5 et 6 - > 1 km

- CR 18 : méthode observation :

- A : oeil nu au sol

- B, C et D : instruments optiques

- CR 20 : forme objet principal : K - ponctuelle

- CR 23 : couleur : toutes 1 à 1

- CR 28 : hauteur angulaire : 1, 2, 3, 4, 5 - de 0° à 90°

Autres actions :

- appliquer le test aux cas (A U B) ; si échec, chercher pourquoi et redéfinir le test ;

- la loi de BOUGUER lie deux grandeurs, sa vérification peut permettre de ranger plus quantitativement les modalités du critère 22, luminosité à partir d'un test basé sur des probabilités d'observation liées aux volumes délimités par les classes de hauteur angulaire, sachant que la vérification du test est assurée.

COMMENTAIRE

- il y a une erreur dans le raisonnement de POHER, c'est d'appliquer une loi valable pour

les objets situés à l'infini. Dans la mesure où les observations sont faites dans

l'atmosphère, le seul facteur d'extinction est la distance entre le phénomène et le témoin.

Avec : d = h/sin (Théta)

- Il semble plus intéressant et susceptible d'ouvrir des voies d'études plus fructueuses, de considérer ce travail comme un essai de modélisation du phénomène en tenant compte d'un modèle de la perception humaine, que comme une preuve de l'existence objective des OVNI.

4.2. MODELISATION SPATIALE

4.2.1. Hypothèse

Le phénomène se produit de façon équiprobable dans l'espace, c'est ce que nous allons essayer de vérifier, suivant plusieurs modalités.

4.2.2. Direction azimutale

On peut penser que les volumes engendrés par les directions azimutales sont égaux, on devrait obtenir des nombres égaux d'observations :

4.2.3. Hauteur angulaire

Les hauteurs angulaires sont codées ainsi :

- de 0° à 15°

- de 15° à 30°

- de 30° à 45°

- de 45° à 60°

- de 60° à 90°

Ces classes délimitent des volumes. Ainsi, pour la distance, il faut décider comment choisir les limites du volume.

Exemple :

- ciel clair : a priori sphérique - secteur sphérique angulaire

- ciel nuageux : ici problème de définition du volume pour les hauteurs entre 0 et 15°

Autre exemple :

- campagne : quelques obstacles : arbres

- ville : maisons, immeubles. ici, un modèle des obstacles en milieu urbain et rural serait utile ( cf. les objets fractals - MANDELBROT ).

RESULTATS :

| Hauteur angulaire | Résultats | Fréquences prévues | Nombres prévus |

| 0 - 15 | 24 | 0,26 | 17,16 |

| 15 - 30 | 11 | 0,24 | 15,84 |

| 30 - 45 | 12 | 0,21 | 13,66 |

| 45 - 60 | 7 | 0,16 | 10,56 |

| 60 - 90 | 12 | 0,13 | 8,58 |

Xhi2 =7.02 à 4° de liberté

| Direction azimutale | Résultats | Fréquences prévues | Nombres prévus |

| Nord | 10 | 0,125 | 11,88 |

| Nord-est | 12 | 0,125 | 11,88 |

| Est | 14 | 0,125 | 11,88 |

| Sud-est | 17 | 0,125 | 11,88 |

| Sud | 10 | 0,125 | 11,88 |

| Sud- ouest | 9 | 0,125 | 11,88 |

| Ouest | 7 | 0,125 | 11,88 |

| Nord-ouest | 16 | 0,125 | 11,88 |

Xhi2=7,31 à 7° de liberté.

4.2.4. Distance

La distance minimale d'observation est codée de la façon suivante :

- 3 cases pour la distance chiffrée

- 4ème case pour la classe :

- M : mètres (de 0 à 999 m)

- R : kilomètres (de 1 à 3 km)

- A : > 3 km

Exemple donné :

- 55 mètres 055M

- 1,5 km 1.5K

Dans le fichier, on trouve :

- 005K contrairement au codage

- 001K et 999M quelle est la différence ?

- 010A conformément au codage

Il s'agit de retrouver ensuite la mesure de la distance ( en mètres par exemple ) et d'affecter cette observation à une classe de distance pour effectuer un test en Xhi2.

Il est évident à ce stade, qu'il s'agirait de faire intervenir la perception humaine pour tenir compte des limitations de celle-ci. C'est pourquoi nous allons présenter quelques notions de psychologie tirées de réf . PIERON.

4.3. PSYCHOLOGIE OBJECTIVE

- Seuil

Point où la valeur croissante d'un stimulus commence à exercer un effet sensoriel déterminé :

- éveiller une sensation (seuil absolu)

- entraîner une modification discriminante d'une sensation (seuil différentiel successif).

- Conception de FECHNER

FECHNER, à partir des résultats expérimentaux indiquant la constance de la valeur relative des accroissements juste perceptibles avait conclu à la validité d'une loi obtenue en faisant un passage à l'infiniment petit de :

Delta perçu = k (Delta à percevoir)/ (à percevoir)

puis en intégrant l'équation différentielle obtenue, ce qui donne :

perçu = k log (à percevoir) + h

- Mesure du seuil par la méthode constante

Le seuil est défini comme étant la valeur qui a autant de chances de ne pas être atteinte que d'être dépassée. Mesure du seuil discriminatif spatiale d'acuité tactile : 8 écarts équidistants ont été utilisés, chacun 20 fois.

On obtient :

Par exemple, dans l'étude POHER, il convient de choisir des objets lumineux ponctuels, de mouvement & de forme anodins. D'un point de vue psychologie de la perception, faire des hypothèses comme la précédente c'est essayer de répondre à la question : "qu'est-ce qui fait qu'on remarque quelque chose ?" ( ici dans le ciel ).

Il faudra alors faire une hypothèse sur les grandeurs proposées à la perception du témoin par exemple pour l'étude de POHER : une luminosité unique, des luminosités équiprobables, etc...

Et, dans la mesure où l'on fait l'hypothèse qu'une grandeur physique est responsable de la probabilité de vision d'un objet, Il faut faire en sorte de choisir pour tester cette hypothèse, les observations où seule intervient cette grandeur.

4.4. LOI DE HARTMANN

Dans le rapport CONDON, une étude a été publiée par le Dr. HARTMANN sur le processus de perception, d'interprétation et d'émission de rapports d'observations.

Le modèle élaboré par HARTMANN conduit à une loi ( dite : loi de HARTMANN ) :

Nr = Cr . N . t

- Nr = Nombre d 'obs.

- N = Nombre d'habitants survolés

- t = durée du survol

- Cr = constante évaluée par HARTMANN entre 1/3,5.107 et 1/1,5.106 homme/s

POHER dans une étude a estimé cette constante pour la FRANCE, comme étant de l'ordre de 1 à 2.10-6. Nous avons voulu vérifier cette loi sur le fichier Gendarmerie du GEPAN ( cas D ) en utilisant une répartition par département.

La répartition est indiquée ci-dessous elle ne permet pas de vérifications de l'ordre de celle qu'on voulait faire. L'intérêt de travailler sur le fichier GEPAN est qu'il a une certaine homogénéité mais il n'est pas actuellement assez étendu pour certaines études.

Rapport du nombre d'observations en fonction des départements français :

| Nbre d'obs. | Numéros des départements |

| 0 | 1 . 3 . 5 . 12 . 14 . 18 . 20 . 22 . 23 . 24 . 25 . 27 . 36 . 37 . 40 . 43 . 44 . 46 . 48 . 56 . 57 . 63 . 65 . 70. 74 . 75. 84 . 90 . 91 . 92 . 93 . 94 . 95 . 78 |

| 1 | 2 . 4 . 6 . 9 . 10 . 15 . 16 . 19 . 30 . 31 . 32 . 35 . 39 . 42 . 47. 49 . 50 . 53 . 58 . 61 . 64 . 66 . 67 . 72 . 77 . 79 . 80 . 81 . 86 . 87 . 89 |

| 2 | 7 . 8 . 11 . 13 . 26 . 28 . 33. 45. 51. 60 . 68. 73 . 85 |

| 3 | 34 . 52 . 69 . 82 . 83 . 88 |

| 4 | 17. 29 . 34 . 62 |

| 5 | 38 . 55 |

| 6 | |

| 7 | 59 |

5. COMMENT ÉTUDIER UNE HYPOTHESE :

PLAUSIBILITE ET CONFIRMATION

5.1. PLAUSIBILITE

Nous citerons ici un article de POLYA, auquel nous avons déjà fait référence dans le rapport de séminaire : "Intelligence artificielle et recherche heuristique (MA 78.79) ". (Ecole Centrale).

5.1.1. probabilité

Point de vue objectif : ex. 1300 garçons/2500 naissances --> fréquence 0,52. On cherche à prédire les fréquences observables à partir des fréquences observées.

Point de vue subjectif : mesurer la croyance en telle ou telle chose. Par exemple : véracité d'un théorème.

5.1.2. Degré de proximité - degré de croyance

Chaque étape de la recherche s'accompagne d'un changement d'attitude du chercheur.

Proximité : intensité éveillée par un problème donné, plus espoir d'en trouver la solution.

Croyance : commence-t-on à chercher si T est vrai ou faux ?

5.1.3. Application des probabilités

La probabilité est mesurée par un nombre déterminé entre 0 et 1. A une plausibilité, on fera correspondre une variable entre 0 et 1 ( ou nombre indéterminé ).

Véracité d'un théorème :

Po (T) : plausibilité puis P1(T) , P2 (T) , . . . etc. . .

Si aucun effet :

Po (T) = P1 (T) = P2 (T)

si T réfuté : P (T) = 0

si T démontré : P (T) = 1

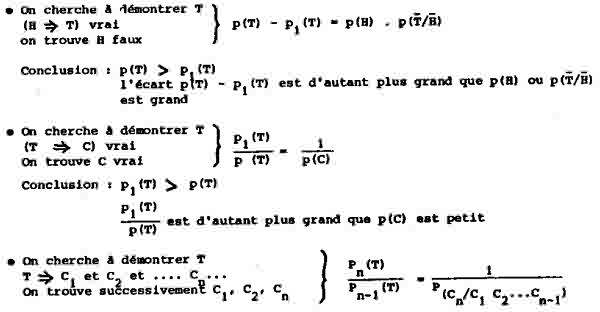

5.1.4. Exemples d'application

Conclusion :

- 1er cas : Cn : conséquence logique des n-1 premières vérifications

P(Cn/C1 C2.....Cn-1) = 1 et Pn(T) = Pn-1 (T) - 2ème cas : Cn : nouvelle conséquence Pn(T) Pn-1 (T) et moins Cn est une conséquence des n-1 Ci, plus P(Cn/C1 C2..... Cn-1) ˜ 0 et plus Pn(T) > Pn-1 (T)

5.1.5. Commentaire

Il manque les moyens d'évaluer la plausibilité d'un phénomène, les lignes précédentes montrant seulement l'évolution de cette plausibilité.

5.2. CONFIRMATION

Nous citerons ici un article de W.C. SALMON "confirmation" Scientific American - Mai 73 :

Pendant des siècles, des chercheurs ont testé, confirmé et réfuté des hypothèses par l'observation et l'expérience. Pourtant, la logique du processus est encore loin d'être comprise.

- - Paradoxe du corbeau noir (Carl G. HEMPEL)

Des observations de corbeaux noirs ( en l'absence d'observation de corbeaux d'autres couleurs ) seront généralement prises comme des confirmations de la généralisation "tous les corbeaux sont noirs". Cette assertion est logiquement équivalente à "toutes choses non noires sont des non-corbeaux". Donc l'observation de choses noires par exemple "un vase vert" confirmera cette deuxième assertion et par suite la première.

- - "les porcs ont des ailes" (RUSSEL)

Considérons l'hypothèse "les porcs ont des ailes". En conjonction avec le fait observé ( condition initiale ) que le porc est bon à manger, nous déduisons la conséquence - nous prédisons - que des créatures ailées sont bonnes à manger. Quand nous voyons que des personnes apprécient le canard, ou la dinde, nous observons que la conséquence - ou prédiction - est vraie ; il semble donc que nous ayons eu une confirmation de l'hypothèse de départ.

- - "Blert-veu" paradoxe

Deux couleurs particulières sont définies. Considérons un point to dans le futur (31.12.2000). Un objet sera veu pendant la période s'étendant sur le 20ème et 21ème siècle, s'il est vert pendant le 20ème et change au bleu au 21ème. Blert est défini de façon analogue : un objet sera blert pendant la période s'il est bleu avec to et vert après. Normalement nous dirions que l'observation d'émeraudes vertes ( en l'absence d'observation, d'autres émeraudes d'autres couleurs ) tend à confirmer la généralisation "toutes les émeraudes sont vertes". Puisque la date actuelle est avant la date (31.12.2000) l'émeraude observée comme étant verte est aussi observée comme étant veu et confirme ainsi l'hypothèse "toutes les émeraudes sont veu". Comment alors devrions-nous prédire quant aux émeraudes du 21ème siècle ?

- - Scientifiques et micro-organismes

Puisqu'il est très probable que prenant un scientifique parmi tous ceux qui ont vécu et vivent, que ce soit un contemporain ( on estime que 90 % de tous les scientifiques sont vivants aujourd'hui ) et puisque il est très probable que prenant un organisme vivant aujourd'hui, ce soit un micro-organisme, alors étant donné que SMITH est un scientifique, il est probable qu'il soit un micro-organisme.

PROBABILITE

Le meilleur antidote contre les erreurs qui viennent de l'intuition en étudiant la confirmation est de se rapporter à la théorie des probabilités. Si la confirmation peut être vue comme un type de probabilité, il est facile de montrer que les relations de confirmation ne sont pas transitives. Il peut aussi être montré que la vérité d'une conséquence d'une hypothèse n'augmente pas nécessairement la probabilité de cette hypothèse ( POLYA parle de plausibilité ). Il faut aussi lever une ambiguité qui existe entre la confirmation "incrémentielle" et la confirmation "absolue". En effet, on dira que la théorie de la relativité restreinte a été confirmée "incrémentièllement" par expérience ( les horloges ) et est confirmée "absolument'' par le corps des évidences la supportant. La confirmation "incrémentielle" par exemple, a des propriétés inhabituelles.

NON CONFIRMATION

Il faut aussi étudier le cas où le résultat d'une expérience est négatif. Ceci ne peut pas être pris comme la réfutation de l'hypothèse puisque dans l'expérience sont ajoutées d'autres hypothèses pour la réaliser. Considérons l'exemple historique suivant : "Les fausses prédictions de la théorie de NEWTON concernant la trajectoire d'URANUS n'ont pas réfuté la physique de NEWTON mais ont mené à la découverte de SATURNE. Par contre, les irrégularités de l'orbite de MERCURE par rapport à la physique Newtonienne n'ont pas mené à la découverte d'une nouvelle planète, mais plutôt à une mise en question de la mécanique newtonienne puisque elles furent une preuve pour la mécanique d'EINSTEIN."

MOYENS

La position du chercheur actuellement ressemble à celle des mathématiciens qui n'avaient pas formalisé la logique qu'ils employaient. Les paradoxes de RUSSEL ont provoqué une crise dans les fondements des mathématiques. Deux voies semblent permettre des résultats dans l'étude de paradoxes de confirmation. D'abord le théorème de BAYES en probabilité, et enfin la reconnaissance du concept de confirmation incrémentielle pour définir une mesure au moyen de laquelle la confirmation incrémentielle sera étudiée.

"tous" et "presque tous" peuvent être très différents. Si tous les A sont des B et tous les B des C, il est vrai que tous les A sont des C (gauche). Pourtant bien que presque tous les scientifiques A soient vivants (8) et que presque tous les vivants (B) soient des micro-organismes (C), aucun scientifique n'est un micro-organisme.

6. CONCLUSION

Le GEPAN a choisi d'étudier le phénomène OVNI d'une façon scientifique. Pour citer JP. ROSPARS, disons qu'il n'y a pas de sujet indigne de la science, mais que des méthodes indignes d'elle. Le problème du GEPAN est donc un problème de méthodes.

Le point crucial dans les actions du GEPAN est évidemment l'expertise. La mise au point "d'instruments de mesure" semble nécessaire pour relayer l'expert dans son travail. Cela est particulièrement frappant dans le cas de contactés avec messages.

La menée de l'étude statistique, de modélisation, ou de description de données sera facilitée par des outils informatiques faciles à utiliser, ne nécessitent que la définition de quelques paramètres pour que le traitement soit réalisé.

Il est entendu que ces traitements seront d'autant plus validés, appliqués à l'ensemble ou à des sous-ensembles des objets identifiés, ils "collent avec l'expertise.

Il sera intéressant de suivre les développements d'études de sujets extérieurs au phénomène OVNI, intéressants soit parce que leurs résultats pourront être inclus dans les études du GEPAN, soit parce que des outils nouveaux seront développés et auront leur place au GEPAN.

Dans le même ordre d'idée, des tentatives de formalisation des étapes de la méthode scientifique, seraient utiles pour le GEPAN dans d'éventuels discours épistémologiques.

CONCLUSION

par Alain ESTERLE

Nous avons vu dans les chapitres 1, 2 et 3 comment s'articulait la démarche du GEPAN pour saisir les données, les expertiser, les classer, les coder et en tirer une image statistique.

Les techniques mises en oeuvre ne doivent en aucun car être considérées comme une méthodologie définie une fois pour toutes conduisant nécessairement à une conclusion correcte, et ceci pour deux raisons :

dune part, des difficultés pratiques et logiques apparues dans l'utilisation de cette démarche,

d'autre part, une réflexion générale a permis de mieux comprendre les fondements de ces difficultés et la possibilité de développer d'autres approches ( chapitres 4, 5 et 6 ).

La démarche utilisée a donc permis de catalyser la réflexion sur la méthode autant que sur son objet. Mais, au stade préliminaire où nous en sommes, il n'était pas possible d'en attendre plus.

Ceci signifie que nous sommes à la veille d'une redéfinition globale des principes du pré-traitement non plus inspirée seulement des techniques antérieures ( classification, expertise, codage ) mais trouvant sa source dans la spécificité même du problème traité et l'originalité des données disponibles.

Cette redéfinition est actuellement en cours. Après une phase d'expérimentation et d'ajustements, qui prendra quelques mois, cette nouvelle méthode de pré-traitement sera décrite en détail dans une prochaine note technique.

FIN

© CNES